Server en switch connecteren over 40GbE - Technical fact

Update 2025

Stabiel snelheidslandschap sinds 2022

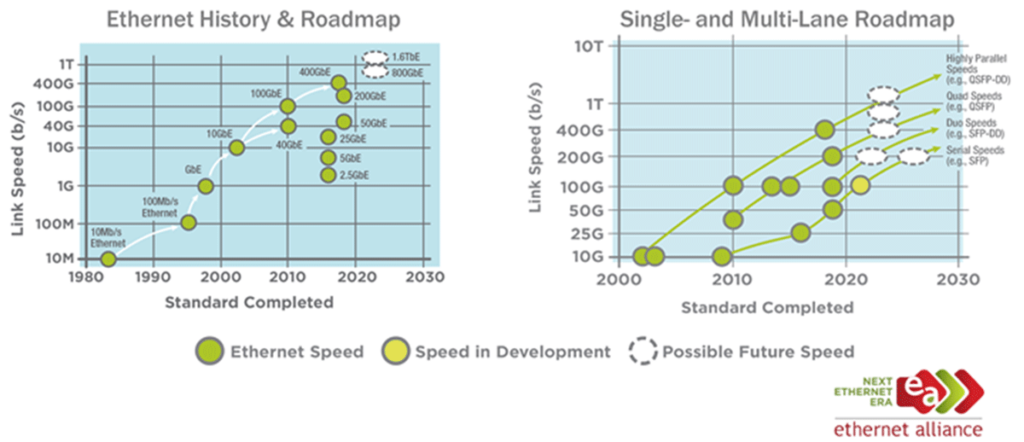

Sinds het oorspronkelijke artikel in 2022 is het landschap van datacenter-netwerken stabiel gebleven, met enkele duidelijk zichtbare trends. De standaard qua host-aansluitingen ligt vandaag vooral bij 10GbE of 25GbE. Hogere snelheden zoals 40GbE of 100GbE zien we nog nauwelijks, behalve bij uplinks tussen switches of datacenters. Met andere woorden: op 3 à 4 jaar tijd is er geen grote verschuiving geweest in de basisinfrastructuur van de meeste klanten.

40GbE groeit in interesse, maar breekt nog niet door

Wat we wel merken, is dat meer en meer aanvragen van klanten aangeven dat nieuw materiaal 40GbE-capable moet zijn. Zowel klanten als leveranciers anticiperen dus op een toename van 40GbE in de nabije toekomst. Voorlopig blijft het echter nog een investering bovenop de bestaande infrastructuur, omdat de prijs van 40GbE-connectiviteit nog niet voldoende gedaald is om als standaard door te breken.

800GbE van ‘future-proof’ naar realiteit

Een opvallende versnelling zien we aan de bovenkant van het snelheidspectrum: 800GbE is ondertussen realiteit geworden, waar dit vier jaar geleden nog als “future-proof” werd beschouwd. Dit benadrukt dat terwijl de dagelijkse hostconnectiviteit langzaam evolueert, backbone- en datacenterlinks wel stevig in snelheid toenemen.

De rol van de Ethernet Alliance

Voor wie het grotere plaatje wil begrijpen, is het interessant om te kijken naar de Ethernet Alliance en hun Ethernet Roadmap. De Ethernet Alliance is een wereldwijde, neutrale organisatie die bedrijven, leveranciers en gebruikers samenbrengt die Ethernet-technologie ontwikkelen en implementeren. Het doel van de Alliance is om kennisdeling, standaardisatie en interoperabiliteit te bevorderen, zodat Ethernet-ecosystemen wereldwijd efficiënt en betrouwbaar kunnen functioneren.

Wat de Ethernet Roadmap onthult

De Ethernet Roadmap die de Alliance publiceert, biedt een overzicht van bestaande en toekomstige Ethernet-snelheden en -standaarden. Het laat zien welke snelheden vandaag gangbaar zijn (bijvoorbeeld 10GbE en 25GbE voor hostconnectiviteit) en welke technologieën de komende jaren relevant worden, zoals 40GbE, 100GbE, en zelfs 800GbE. Voor datacenter-architecten, IT-managers en klanten is deze roadmap een waardevol hulpmiddel bij investeringsbeslissingen: ze helpt bij het inschatten van toekomstige compatibiliteit, het plannen van migraties en het voorkomen van investeringen die snel verouderd raken.

Een gids voor toekomstbestendige keuzes

Door de roadmap te volgen, kunnen organisaties dus bewuster keuzes maken over welke netwerkuitrusting vandaag aan te schaffen is, en hoe ze hun infrastructuur toekomstbestendig kunnen maken. Het is een duidelijke gids in een landschap waar de snelheid van Ethernet-links enerzijds langzaam evolueert bij hosts, maar anderzijds snel opschaalt bij backbone- en datacenterverbindingen.

Bron: Ethernet Alliance – Ethernet Roadmap 2025. Beschikbaar via: https://ethernetalliance.org/technology/ethernet-roadmap/

Oorspronkelijk artikel

Wat was het probleem?

Draai je nog steeds op trage 10 GbE legacy-netwerken?

Dit lijkt een vreemde vraag, gezien we bestaande klanten nog steeds migreren van 1GbE naar 10GbE-technologie. De 10GbE ethernetstandaard werd echter voor het eerst geïntroduceerd in 2002! (Bijna 20 jaar geleden!)

Dit gezegd zijnde, hadden we onlangs een klant die zijn nieuwe Nutanix-configuratie wilde opzetten met behulp van 40GbE-standaarden in plaats van 10GbE. Niet zo gek, want de investering gebeurde voor 5 jaar. Over 5 jaar wordt 40GbE wellicht ook als standaard beschouwd (wie weet?).

Bij het opzetten van een Nutanix-omgeving, vooral I/O-intensieve omgevingen, valt er iets te zeggen over de keuze voor een netwerk met hoge snelheid (en lage latentie). Dit aangezien het storage verkeer ook over de ethernetkabels wordt verzonden. Omgevingen die afhankelijk zijn van flashopslag vinden soms hun nieuwe knelpunt bij ethernetsnelheden. Het is een eindeloze oefening om knelpunten te omzeilen, wetende dat elke keer dat er een wordt opgelost, er een nieuwe zal opduiken.

Voor mij was het vrij nieuw om deze machines via 40GbE te verbinden. Ik had veel vragen over transceivers, kabels, aansluitingen, etc. Het bleek dan ook best lastig om uit te zoeken hoe je deze apparaten precies met deze standaard kunt verbinden. Vandaar dus deze blog!

Kristof's aanpak: connectie server en switch over 40GbE

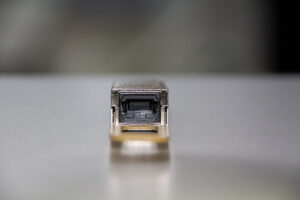

Laat ik aan de serverzijde beginnen. De Nutanix nodes (in dit geval, maar je kunt het veralgemenen naar “compute nodes”) hadden 40GbE Mellanox-adapters geconfigureerd. Zoals je op onderstaande afbeelding kunt zien, hebben deze 40GbE-adapters geen gewone SFP+- of SFP28- connectoren. De vormfactor van deze poorten (en transceivers) is QSFP28.

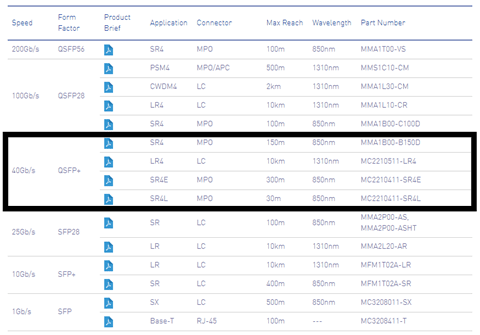

Zoals altijd worden dergelijke adapters niet geleverd met transceiver modules. De reden hierachter is dat je deze transceivers in veel verschillende smaken kan configureren (verschillende connectiviteit, verschillende afstandsondersteuning, enz…). Voor deze specifieke klant was de afstand tussen switch en servers minder dan 100 meter. Kijkend naar de datasheet van de adapter, kwamen we erachter dat voor 40GbE en een afstand tussen server en switch van minder dan 100m slechts 1 type transceiver geschikt was.

Onderstaande tabel bracht zeker enkele vragen met zich mee met betrekking tot de connectiviteit. Wat is deze SR4-standaard precies en wat zijn de MPO connectoren? Het werd duidelijk dat deze adapter geen LC-connectoren zou ondersteunen zoals we allemaal weten (de typische glasvezelkabels), maar we hadden “MPO-kabels” nodig. MPO-kabels (Multi-Fiber Push On) zijn aan beide uiteinden voorzien van MPO-connectoren. Een MPO-connector is een connector voor ribbon kabels met ten minste 8 fibers, die is ontworpen om multi- fiber connectiviteit in één connector te bieden ter ondersteuning van toepassingen met hoge bandbreedte en bekabeling met hoge dichtheid.

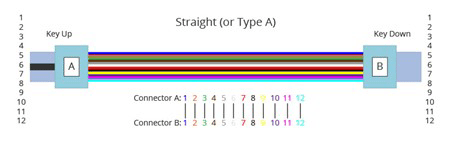

Nu we wisten dat we MPO-kabels nodig hadden, was er nog een hindernis te nemen. Er waren namelijk meerdere implementatiemethoden mogelijk, genaamd “polariteit“. De drie methoden voor de juiste polariteit gedefinieerd door de TIA 568 standaard worden genoemd als methode A, methode B en methode C. Om aan deze normen te voldoen, worden drie soorten MTP-fibers met verschillende structuren genaamd Type A, Type B en Type C gebruikt voor de respectievelijk drie verschillende connectiviteitsmethoden.

MTP Trunk-kabel Type A: Type A-kabel, ook wel rechte kabel genoemd, is een rechte kabel met een key-up MTP-connector aan het ene uiteinde en een key-down MTP-connector aan het andere uiteinde. Hierdoor hebben de fibers aan elk uiteinde van de kabel dezelfde positie van fiber. De fiber die zich bijvoorbeeld op positie 1 (P1) van de connector aan de ene kant bevindt, komt aan op P1 bij de andere connector. De volgorde van fiber van een MTP Type A-kabel met 12 fibers wordt als volgt weergegeven:

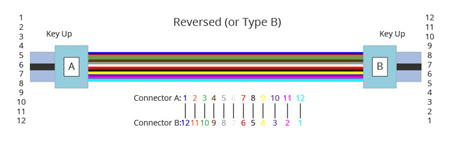

MTP Trunk-kabel Type B: Type B-kabel (omgekeerde kabel) gebruikt een key-up-connector aan beide uiteinden van de kabel. Dit type array koppeling resulteert in een inversie, wat betekent dat de posities van fibers aan elk uiteinde zijn omgekeerd. De fiber bij P1 aan het ene uiteinde is gepaard met fiber bij P12 aan het andere uiteinde. De volgende afbeelding toont de sequenties van fibers van een 12-vezel Type B-kabel.

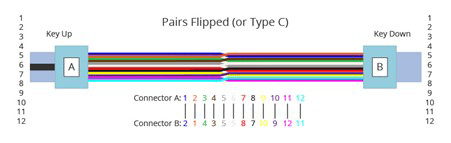

MTP-trunkkabel Type C: Type C-kabel (paren omgedraaide kabel) ziet eruit als een type A-kabel met één key-up-connector en één key-down connector aan elke kant. Bij type C wordt elk aangrenzend paar fibers aan het ene uiteinde echter aan het andere uiteinde omgedraaid. Zo wordt de fiber op positie 1 aan het ene uiteinde verschoven naar positie 2 aan het andere uiteinde van de kabel. De fiber op positie 2 aan het ene uiteinde wordt verschoven naar positie 1 aan het andere uiteinde enz. De volgorde van fibers van Type C-kabel wordt gedemonstreerd in de volgende afbeelding.

In deze case moesten we een switch en een server aansluiten, waardoor we polariteit type B moesten implementeren. En raad eens: een juiste adapter, correcte transceivers aan zowel server- als switchzijde en correcte bekabeling met juiste polariteitsmethode gaven ons een stabiele verbinding! Na het nodige opzoekwerk, konden we deze case dus vlot tot een goed einde brengen.

Heb je behoefte aan meer informatie over dit onderwerp of kun je een ander IT-probleem niet zelf oplossen? Neem contact op, wij helpen je graag verder!

Deze blog dateert van 2022. Houd er rekening mee dat de inhoud mogelijk niet meer actueel is en sindsdien veranderd kan zijn.

Wil je meer weten

Over onze aanpak?

Geef ons een seintje...

Deze blog dateert van december 2022. Houd er rekening mee dat de inhoud mogelijk niet meer actueel is en sindsdien veranderd kan zijn.